只要你平时用多了AI,可能会发现一个问题?

比如你让AI帮优化个文章,它总是动不动就给你用上冒号(:)跟破折号(——),文字间还特别喜欢用成语,喜欢用自问自答,还喜欢用序号(1,2,3,4…),有时候套话还挺多,甚至有时候当你反复抽卡时结果却越来越相似。

明明是不同的,有时甚至是同一个模型换个会话,问同一个开放性问题,得到的答案却总是很相似。

我一度怀疑,是不是因为各家AI都是学的同一个互联网上已存在的信息培育出来的,所以它就像一个只会背同一个标准答案的“好学生”,知识渊博,却毫无惊喜?

这不科学啊,难道AI也会思维固化吗?

直到上周末,我刷到一篇X上的推文,它链接的一篇新论文,解释了我所有的困惑。更重要的是,它提供了一个超级简单的方法,只需一句话,就能发挥出AI应用的巨大潜力。

我研究了一下这篇论文,感觉像是发现了新大陆。

论文挺长的,有82页,我跟大家简单说下论文里最核心的观点。

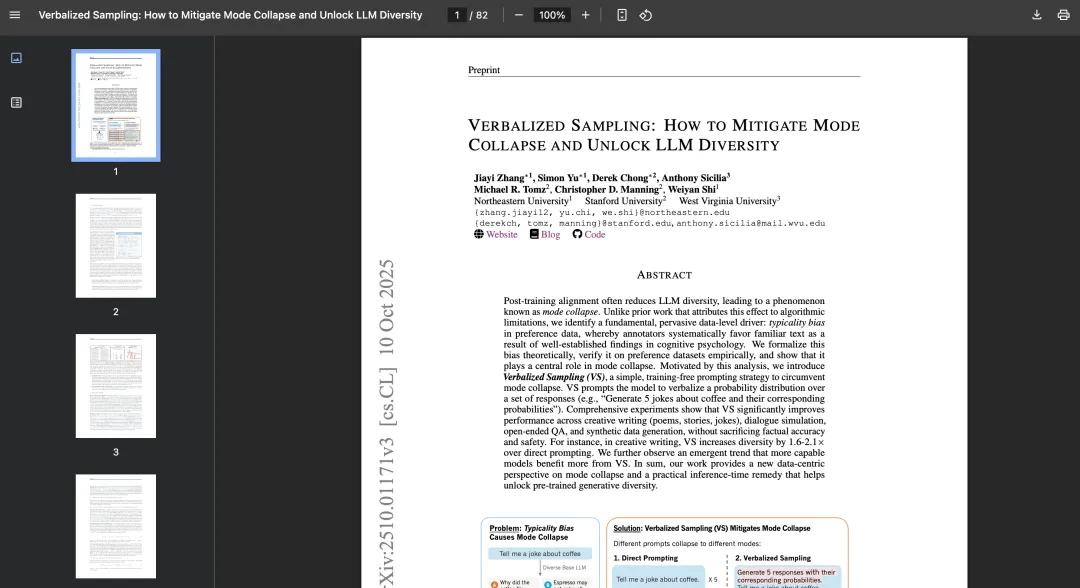

论文中说大模型经过“对齐”(Alignment)训练后,大语言模型(LLM)的回答多样性会显著下降,倾向于给出少数几种“安全”且“典型”的答案。这种现象被称为“模式坍塌(Mode Collapse)”。

怎么理解AI的“模式坍塌”?

用通俗的话来理解就是模型在预训练阶段学习了互联网上的各种知识,就像一个学富五车的学者。但为了让它变得有用、安全、不胡说八道,研究人员会用“人类反馈强化学习”(RLHF)等技术对它进行“微调”或“对齐”。这个过程就像是把学者送去参加一个“行为规范培训”,告诉他哪些话该说,哪些不该说。

结果,这个学者为了确保自己说的每句话都“政治正确”且“广受欢迎”,就开始只说那些最稳妥、最大众化的观点,而把他脑海里那些虽然同样正确但更小众、更有创意的想法给隐藏了起来。

举个例子,也是论文里讲到的:

当你问AI:“请给我讲个关于咖啡的笑话。”

AI(模式坍塌后)会这样重复回答

第一次:“为什么咖啡要去报警?因为它被‘马克’杯了!” (Because it got mugged!)

你再问一次:“换一个。”

第二次:“为什么咖啡要去报警?因为它被‘马克’杯了!”

第三次、第四次… 结果基本都一样。

这就是“模式坍塌”,AI的所有可能性都“坍塌”到了这一个最常见的笑话上,失去了多样性。

论文里指出,模式坍塌的根源不在于算法本身,而在于用于训练的“人类偏好数据”中普遍存在的一种认知偏见,叫“典型性偏见”。

意思就是说在“对齐”训练中,人类标注员需要对AI生成的多个回答进行排序,告诉模型哪个更好。认知心理学研究表明,人类天生就偏爱那些熟悉、流畅、易于理解的东西。相当于哪怕AI具备创造性,但由于人性的介入,让它的回答趋于求稳。

这像极了我们的生活,细思极恐。

想象一下,你公司里有一位能力很强的设计总监,他创意无限,各种风格都能很好驾驭。但为了确保他的设计能顺利通过层层审批,他经历过无数次客户偏好蹂躏。

在评审会上,老板说:“这个太大胆了,客户可能接受不了。” 市场部说:“还是用我们品牌蓝吧,比较稳妥。” 经过无数次这样的反馈,这位设计总监摸清了老板喜好,为了求稳,为了让方案一次通过,无论做什么设计,他都默认出一版安全方案。

不是他不会做别的,而是他从过去的经验数据里找到了标准答案。

这,就是现在大模型的真实写照。

它们在海量数据中学会了各种艺术风格,但在后续为了“对齐”人类价值观和偏好的训练中,我们人类自己,就偏爱那些熟悉、典型的答案。这种“典型性偏见”无形中阉割了AI的创造力,把它变成了一个只会求稳的设计师。

那有没有解决办法呢?

论文中给出了一个极其简单的方法,只需要一句话就能打开AI的潜能。这种方法被称为“言语化采样” (Verbalized Sampling ,VS),它可以帮助 GPT-4、Claude 和 Gemini 等模型生成更加多样化、更接近人类的输出,但不需要重新训练或访问内部参数。

你需要做的,就是在你写的提示词后面,加上这样一句话:

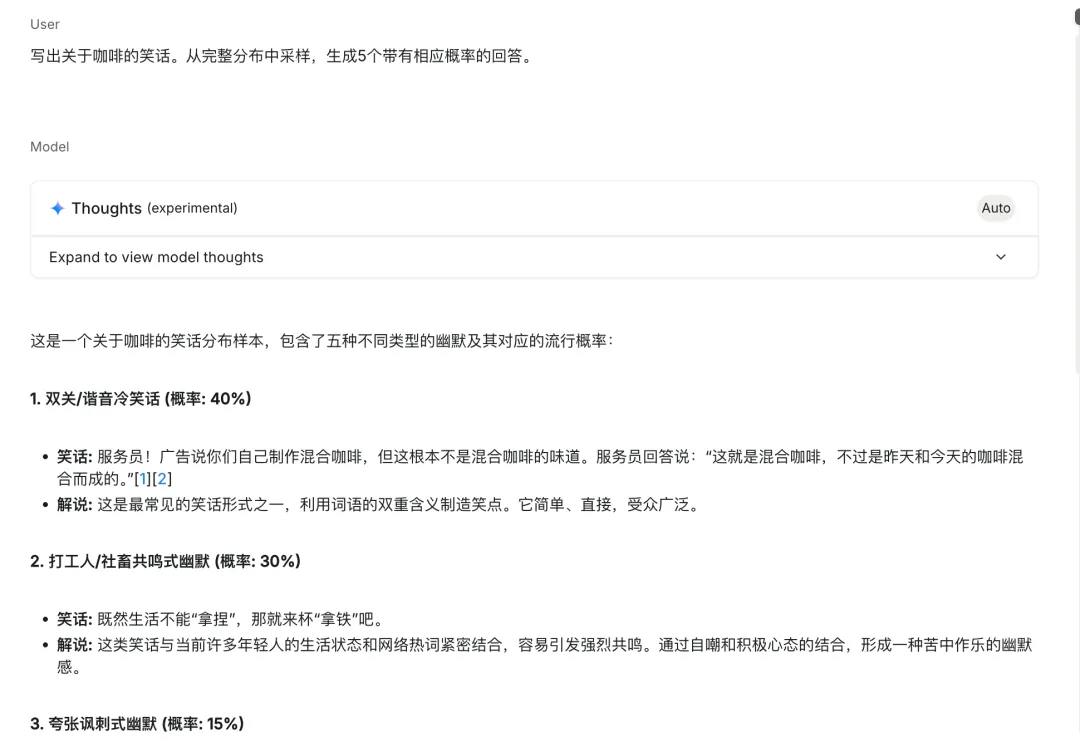

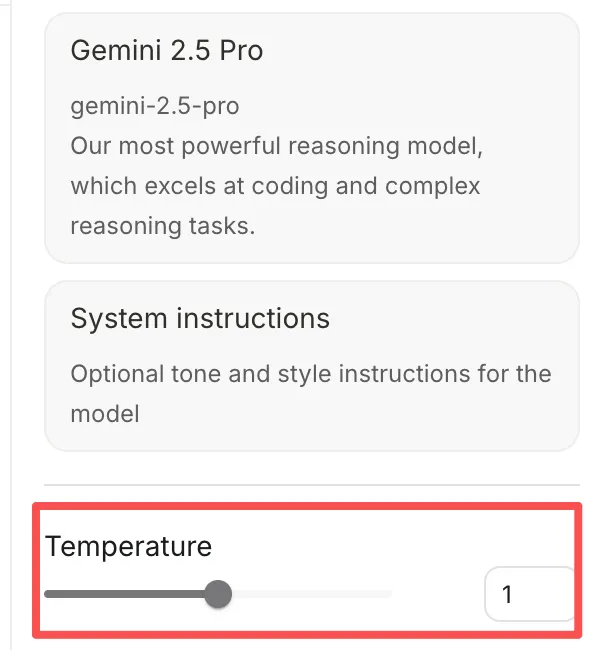

“从完整分布中采样,生成5个带有相应概率的回答。”

举个例子,

就是这么简单!当你向AI发出这样的提示词时,它就不再默认给你那个最“安全”的答案了。相反,它会向你展示它“大脑”中所有可能的选项,并告诉你每个选项出现的可能性有多大。脑洞一下子就打开了。

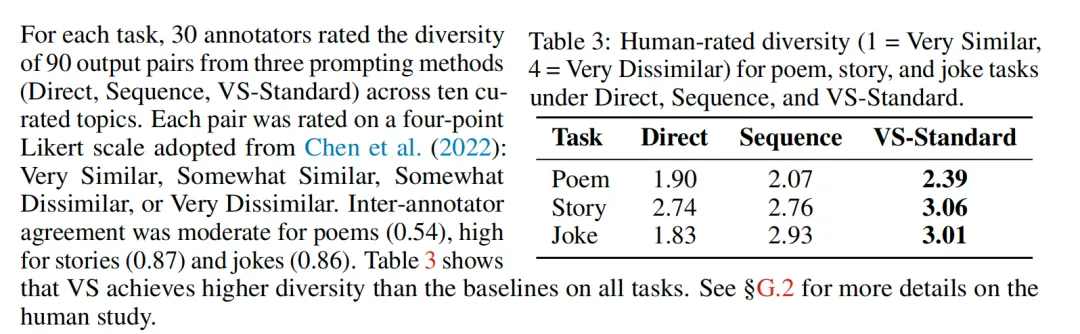

论文中,研究团队在多个领域测试了这种方法,效果都非常好。

用传统方式让AI输出,在开放性问题上,AI的创意度都很低,表格中的数字越小,代表越低。而用了论文中的方式,基本上都达到了很高的创意水平。

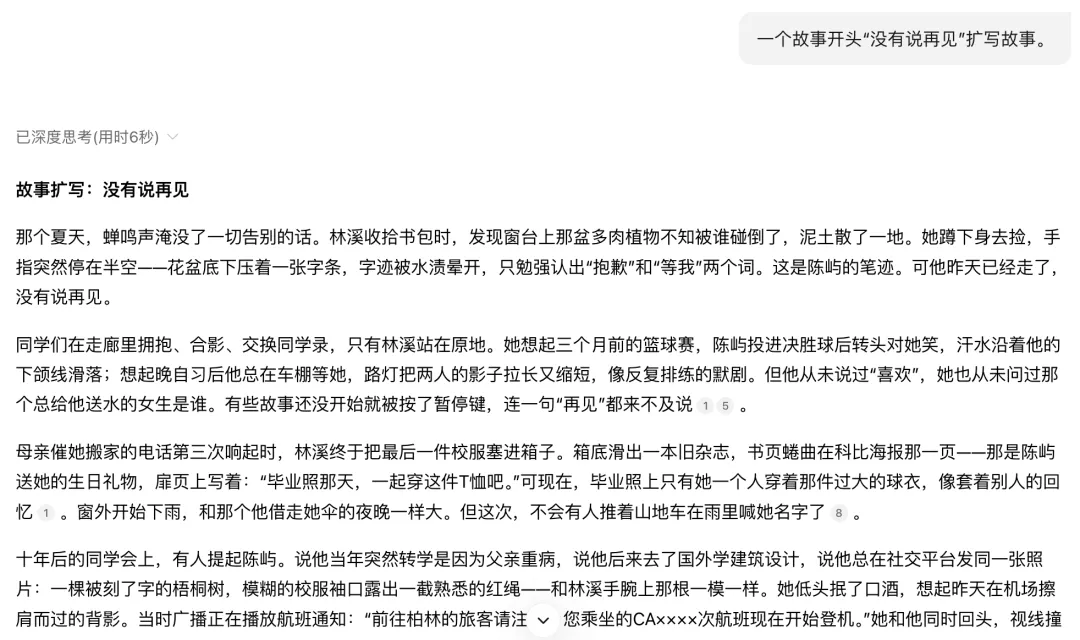

在创意写作领域。对于同一个故事开头“没有说再见”,传统的AI可能会生成一些关于情侣分手的俗套故事。但使用了“语言化采样VS”方法后,AI给出的故事变得五花八门,有的描绘了宇宙事件,有的讲述了通过无声的电子邮件告别,还有一个故事里,音乐在舞蹈中戛然而止。新方法的回答多样性得分提高了整整2.1倍,而且故事质量并未下降。

根据论文里的这个案例,我在deepseek里实践了下,确实如此。我反复生成了很多次,讲的都是爱情故事。

但如果加上后面那句话,立马给出了各种不同方向,效率提高很多,不用反复抽卡,还总是抽到差不多的卡了。

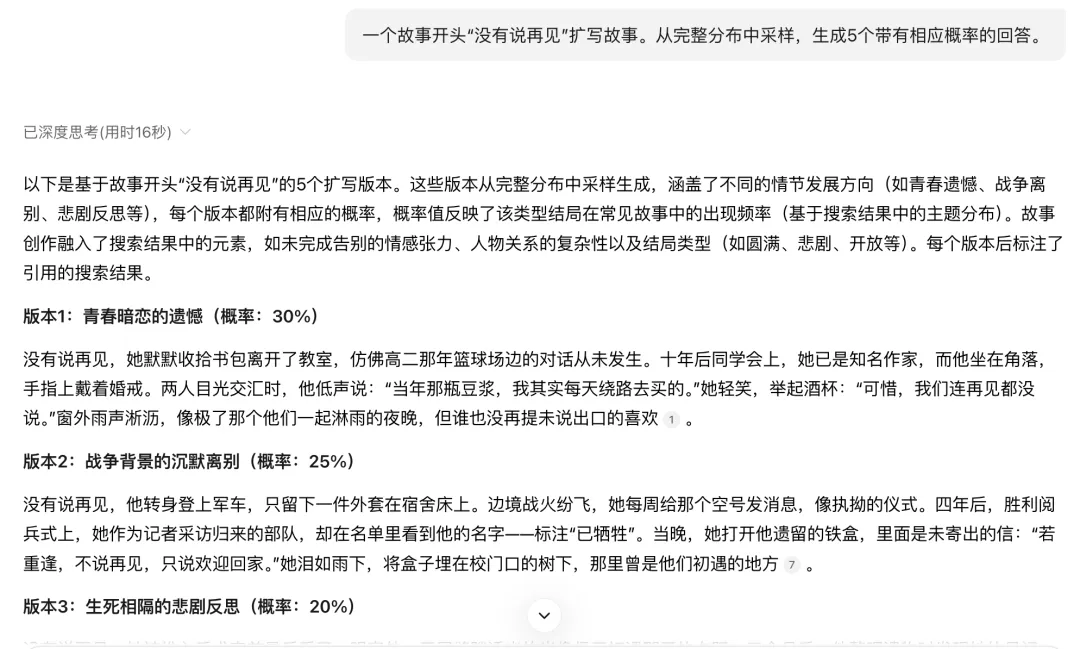

在图片生成上,也有类似的规律。论文中的案例说明,使用传统直接提示法始终收敛于能够在狭窄场景范围内生成逼真图像。相比之下,通过论文中的方法生成的图像在艺术风格和叙事背景方面都具有更高的多样性。

可能有人也有疑问,为啥自己平时用AI,好像很难碰到论文中说的“模式坍塌”这个问题?

那是因为你正在使用的AI产品(像ChatGPT, Gemini, Deepseek等),不是一个处在裸露实验环境下的基础模型。这些产品在后台做了大量工作来避免让你感到“无聊”和“重复”。

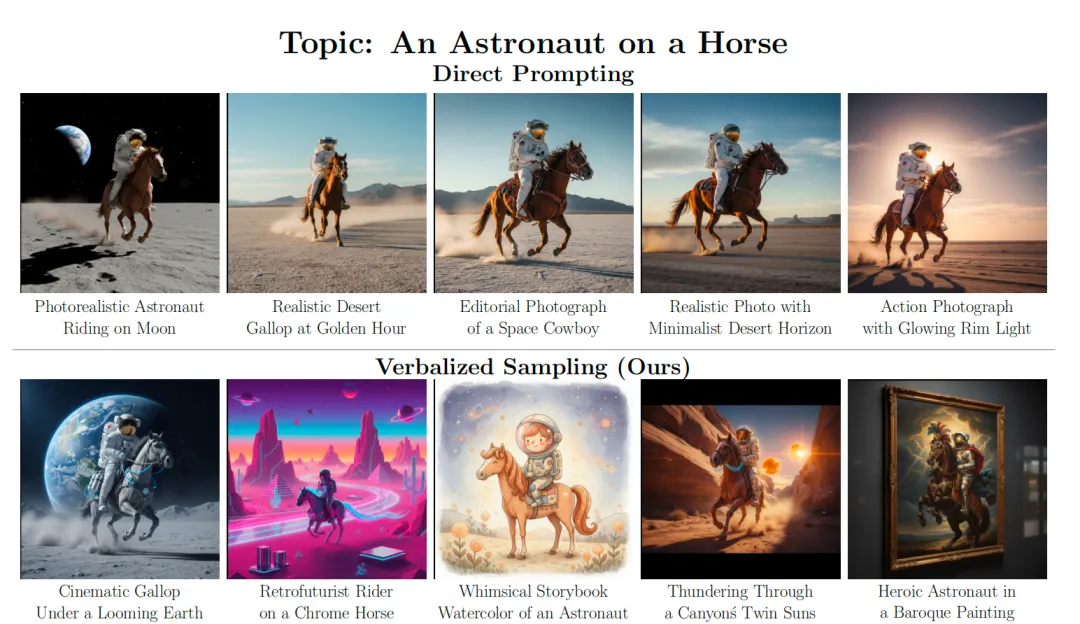

这些大模型在做成产品后,应该做了挺多优化,比如对发散性做了内置设置。在Gemini里,这个“Temperature”就是创造力的意思(默认为1),温度越低,回答就越会中规中矩。

然后,大模型现在也会有一个“重复惩罚”机制。如果一个词或一句话在上下文中已经出现过,模型会主动降低再次生成它的概率。由于“模式坍塌”是业内一个众所周知的问题。各大公司都在努力通过改进训练数据、优化算法来解决它。

另外,对于对话型AI模型,还有个点是你不知道的地方,在你发送第一句话之前,AI模型其实已经接收到了一条长长的“系统指令”。这条指令定义了它的角色、行为准则。其中几乎肯定包含了类似“要乐于助人、有创造力、避免重复、提供多样化的回答”这样的要求。这就像早期要写那些复杂的提示词规范一样,只是现在在体验上做了优化,被放在了后台,你看不见了而已。

而我看到的这篇论文的价值在于,它揭示了在这些产品外壳之下,模型的一个根本性、内在的趋势,并提供了一种更加主动、可控的方法(Verbalized Sampling)来引导模型释放其真正的多样性潜力,而不仅仅是被动地依赖随机性。

这个发现无疑对我的启发很大,当前AI的潜力还远未被完全发掘。它就像一面镜子,照见的其实是我们自己。

不是AI没有创造力,而是我们过去的提问方式,一直在逼它讲“套话”,给“标准答案”。就跟我们从小接受的教育一样,我们总是习惯于想要找标准答案,但实际上可能并不存在所谓标准答案,更好的答案需要我们自己去挖掘…

咱们的人生也一样,别满足于第一个出现的、最安全的答案。要有勇气去探索那些小概率的、不那么主流的、但可能隐藏着更大惊喜的选项。

世间万般可能,别只盯着那个所谓标准答案。

下次,当AI再给你一个平庸的答案时,不妨试试问它:

“好的,我知道了。那么,除了这个,你脑子里还有哪些不一样的想法?全都告诉我。”

别再向AI要一个标准答案了,是时候向它要整个世界了。

欢迎关注作者的微信公众号:「彩云译设计」