面对产品中的 AI 能力,用户的过分信任和不信任都不是好事。如何通过设计让用户建立起合适程度的信任?本文列举了一些具体方法和实例。

本文节选自 Medium 上的《Building and calibrating trust in AI》,原作者 Dr. Janna Lipenkova。

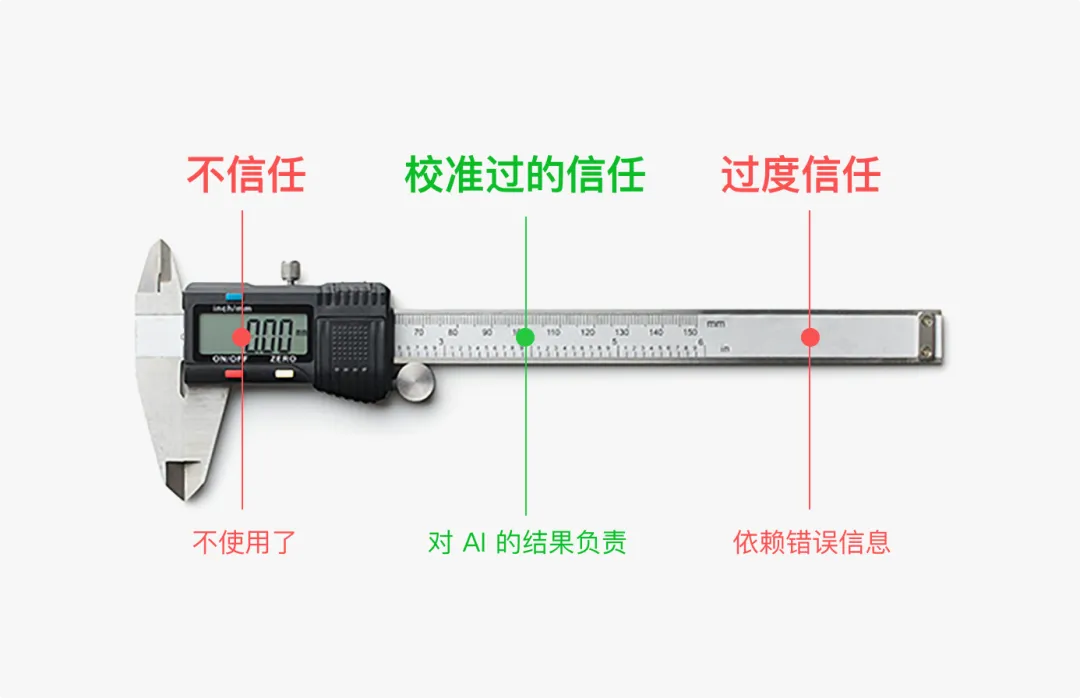

信任连续体:不信任是有害的,但过度信任是危险的。你需要将用户引导到“校准”过的信任平衡点。

信任维系着人与人、人与企业以及人与产品之间的关系。如果一个朋友失踪了一年、一辆车半数时间都无法启动、一名队友总是偷懒,信任就会逐渐消退,我们开始寻找替代品。

实现对 AI 的信任并不简单。AI 本质上就是概率性、不确定、会犯错的。产品需要努力赢得用户信任,而一旦赢得又需要将其回调,因为过度信任也是危险的。用户应该成为负责任的协作者,通过质疑、调整和自主决定系统的使用方式,来校准他们对 AI 的信任。

那么,如何建立用户对 AI 的适当信任呢?AI 团队经常将信任被简化为模型准确性,将信任看作一个技术问题,需要工程师或数据科学家来“修复”。

但这只是一方面。其实信任还通过用户对产品的理解和体验来建立。本文重点关注如何通过用户体验建立和校准信任,介绍了诸多设计模式,来减轻 AI 所犯错误带来的不确定性和风险。

用户与产品交互时,会建立心智模型。如果这些模型与现实不符,信任就会破裂。一个依赖 ChatGPT 的 AI 应用,与使用了深度定制 LLM(大语言模型)的应用,尽管表面上的交互差不多,其行为和输出的结果却不同,而用户看不到其中的过程。

为了避免期望不匹配,你需要打开系统的黑箱,向用户解释工作原理。以下是一些增加 AI 透明性设计模式:

① 上下文解释(In-context explanations):在显示输出结果的地方,当即解释这是如何生成的。例如,可以分解并展示信息源。在图形界面中,可以用 tooltip 等交互元素;在对话界面中,可以在对话流中直接提供解释。

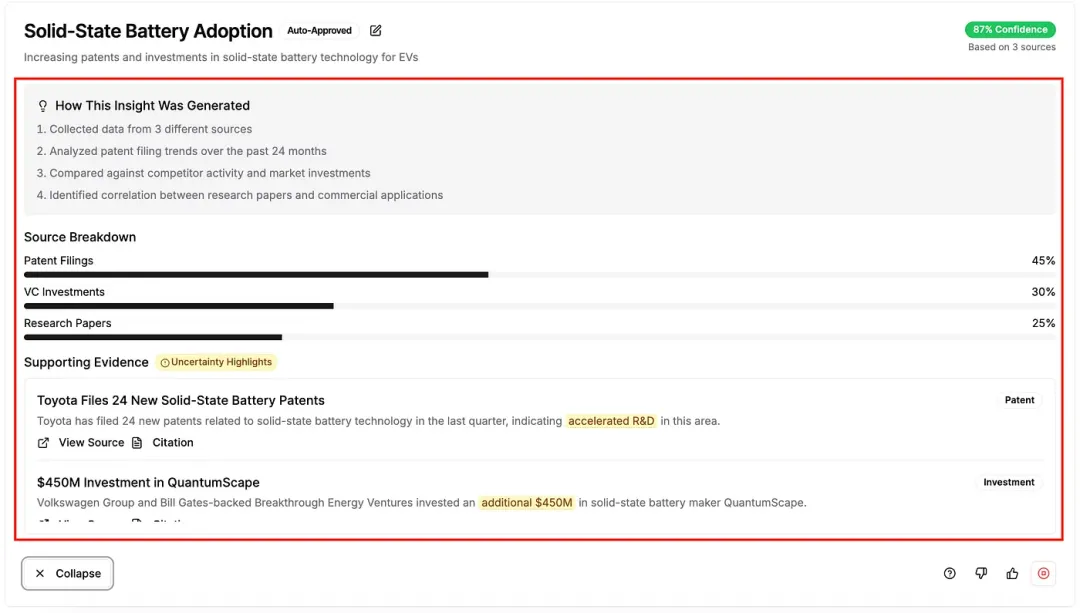

② 思维链(Chains-of-thought):让用户可以追踪 AI 是如何得出结论的。在以下案例中,点击一个 AI 给出的建议,会展示其信息源和整理过程,包括搜集到文档、事件和不同信源的权重。

展示 AI 得出结论的“思考过程”

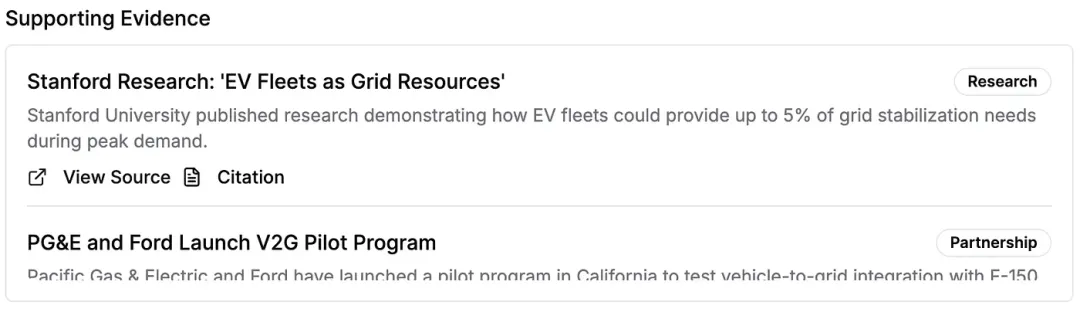

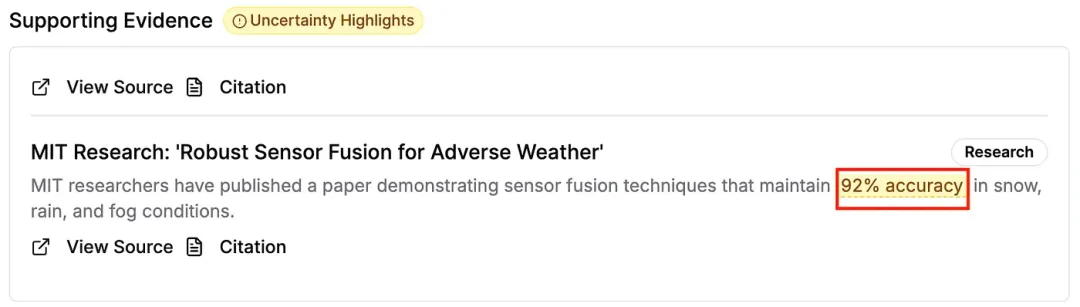

③ 引用(Citations):将输出链接到源数据,无论是文档、报告还是 API,这样用户就可以自行验证 AI 的输出。

显示原始来源,允许用户自行检查数据

④ 持续的告知和引导(Everboarding and guidance):当系统发展变化时,充分告知用户。提供轻量的 tooltips 或页面内指引,以解释有什么变了、会如何产生影响。

⑤ 强调验证的解释(Verification-focused explanations) :不仅解释输出是如何形成的,还需帮助用户评估其可靠性。强调验证的方式包括自我批判(如“此信号可能因某某因素而被夸大”),或提供其他角度的回答,来引导用户自主做出判断。

在设计 AI 体验中的透明度时,要特别注意传达 AI 的不确定性。这将帮助用户校准他们的信任并发现错误。以下是一些技巧:

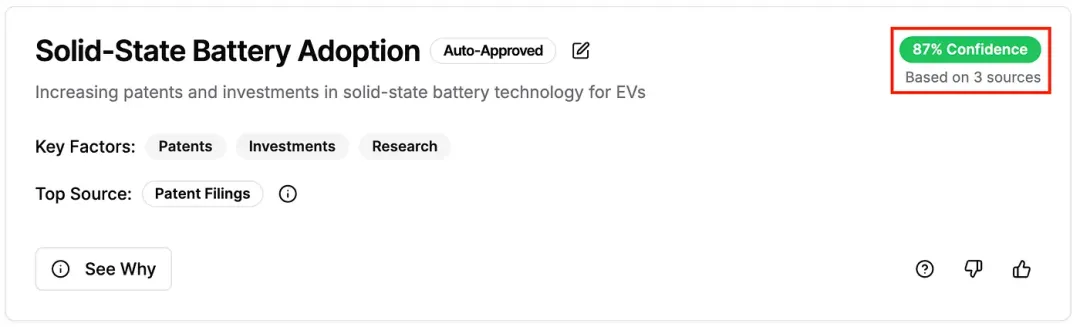

① 置信度分数(Confidence scores):使用简单、可见的指标,如百分比或低/中/高等级,来标示结果的置信度。

置信度分数可以突出显示需要进一步验证的结果

② 对于文本内容,可以在视觉上高亮不确定的部分。

高亮整段文本中不确定的部分,其他部分不受影响。

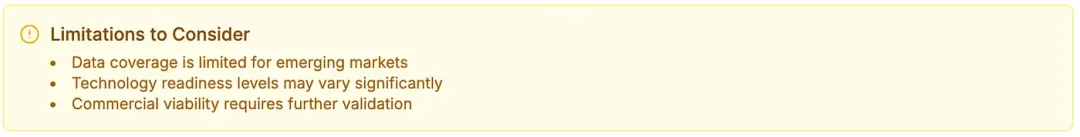

③ 警告和免责声明(Caveats and disclaimers):可用于突出显示输出或数据集的已知限制。如果数据覆盖范围稀疏,或信号冲突,请尽早明确说明,这样用户就不会基于错误的假设做出决策。

主动传达系统的局限性

④ 表达不可确定的内容时,使用谨慎存疑的语气,如“这可能意味着…”,“数据尚无定论…”,“建议进一步验证”等。

AI 的回答是会不断发展的,用户给出反馈、疑问和投诉后,它们将迅速进化。

如果用户不能根据额外的信息采取行动,上述的透明度就没有多大价值。为了让用户能和 AI 协作,需要让用户产生控制权和责任感。以下设计模式可以用在用户使用 AI 之前、期间和之后:

① 任务前设置(Pre-task setup):允许用户在启动分析之前配置AI任务的范围,如数据源、时间范围、实体过滤器。这能提高结果的相关性,避免过于笼统。

② 可调节的信号权重(Adjustable signal weighting):让用户决定不同来源或标准的权重。比如,在趋势监测中,一个用户可能优先考虑风险投资活动;另一个用户可能优先考虑学术引用。并解释不同信号会对结果造成怎样的影响。

允许用户决定对数据源施加的权重

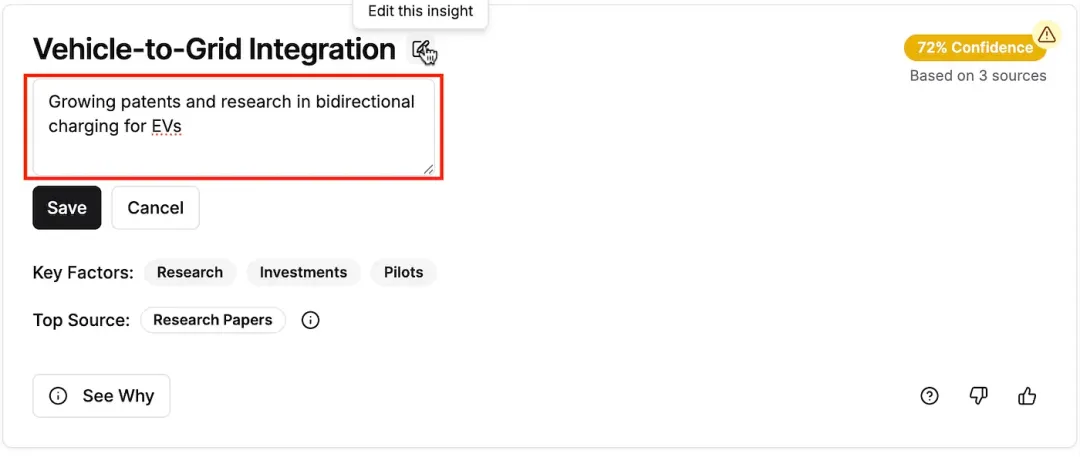

③ 就地编辑和操作(Inline editing and actions):让输出结果能被编辑或替换。允许用户调整表述或设置来优化结果,而无需重新运行整个任务。

支持高级用户基于 AI 生成的结果进行更改

④ 终止生成(Abort generation):允许用户在刚刚发现错误时就停止生成结果。我们在 ChatGPT 等工具中已经体验过,当你在 AI 一开始不太对时就停止它,将节省不少时间。

⑤ 批判性的提示(Intentional friction):通过批判性地对用户发问,让用户思考,如对:“你认为这个结果基于什么假设?”或“你认为这结果是噪音导致的吗?”这些被称为CFF(cognitive forcing functions)。它有助于校准用户过度信任造成的依赖,尤其是在用户对 AI 建立信任的早期。

即使工程师将 AI 性能优化到极致,用户仍会体验到错误。你需要将用户转变为协作者,帮助产品捕捉问题并转化为学习的机会。以下是一些方法:

- 开门见山地强调错误可能发生:让用户刚开始使用产品时,对模型建立切合实际的预期。与其假装完美,不如坦诚告知“大约十分之一的结果可能需要审查”。

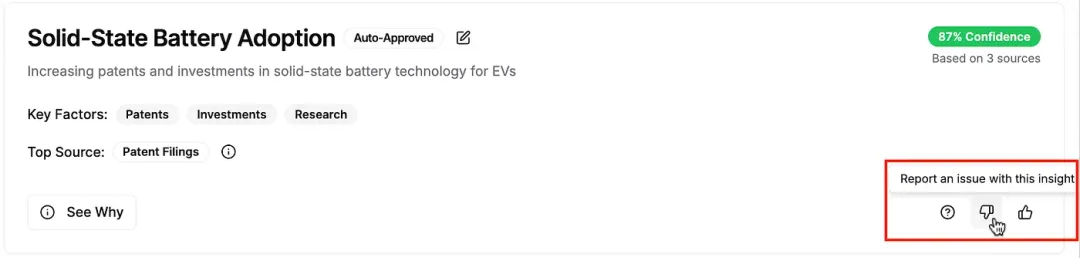

- 支持就地反馈(Inline feedback):让用户能直接在问题发生的地方标记问题,比如错误的分类、误报、过时的数据。

- 即时确认和修复错误:用户提交反馈后,系统应给出可见的响应并提供修复后的结果。“感谢您的标记——您想重新生成不含此错误项的结果吗?”

当用户感到自己的意见是有效的,能真正帮助系统改进,就会加深对系统的信任,不再将 AI 视为黑箱,而是合作伙伴。

首先可以捕捉那些不那么直接的反馈:用户在哪里开始深挖细节?他们编辑或删除了什么?持续忽略了什么?这些行为信号将大大影响结果的相关性。还可以使用更直接明了的反馈机制,比如:

① 二元反馈:一个简单的点赞/点踩,能立即反馈输出的质量。很简单,可以广泛应用。

无处不在的赞/踩反馈能提供浅显但快速的反馈

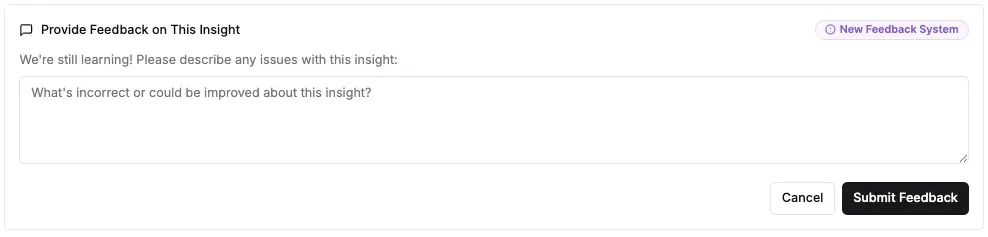

② 自由文本输入:在系统推出早期尤其有用,帮助你了解系统是如何出错的。填写确实需要更更高成本,但可能会带来宝贵的发现。

用文本框收集问题

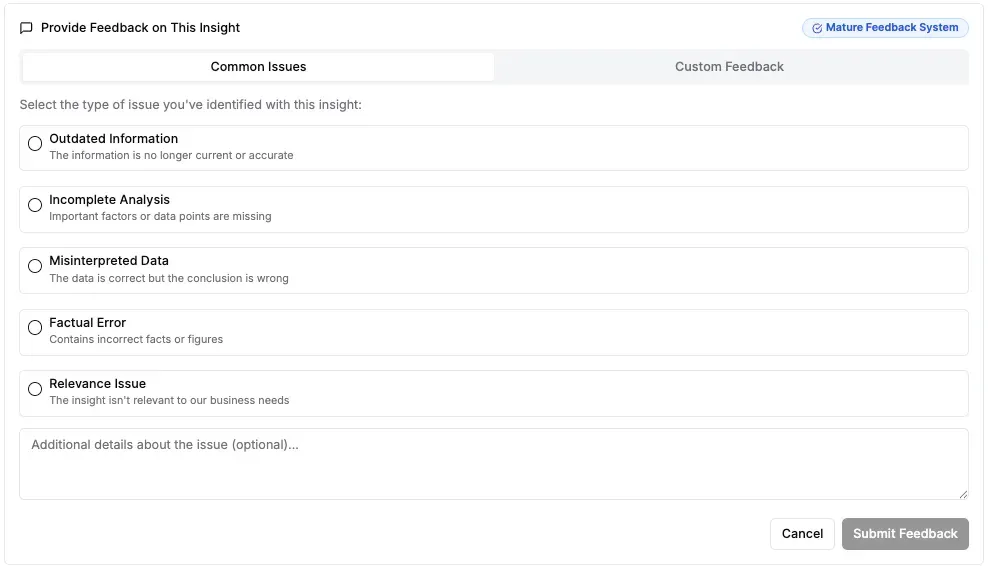

③ 结构化反馈:随着你的系统逐渐成熟,开始发现一些常见的问题模式,就可以为用户提供结构化的反馈方式,来提高反馈效率并减少歧义。

已经有了常见的问题类型时,提供结构化反馈

对产品来说提供这些反馈功能很简单,但用户可能没什么动机去反馈。以下是一些引导用户持续反馈的技巧:

- 清楚地传达反馈的影响。尽可能精确地告知用户反馈的影响:“您的反馈将在本月底的下一次发布中集成。”这样来鼓励用户养成反馈的习惯。当用户知道它是有帮助的,就已经成了一种奖励。

- 考虑实实在在的奖励。比如,为持续反馈的用户提供更加个性化、更多控制权的体验。这不仅可以激励反馈行为,还能在满足高级用户的同时,保持新手用户的简单体验不被影响。

信任是逐渐建立起来的,来自用户在 AI 能力中体验到的每次互动、每次洞察、每次 AI 协助下的决策。随着时间,AI 会改进,产生更相关的结果和更少错误;用户也会改变,变得更熟练、更有依赖性、要求更高。不确定和错误是 AI 与生俱来的部分,建立好信任后,小心审慎的用户也将乐于使用。